인공지능의 결과를 신뢰할 수 있는가?

A금융회사는 페이스북 광고를 이용하고 있다. 페이스북은 자체 알고리즘에 의해 대상자를 선별하고 광고를 노출시킨다. 대상을 무작위로 선정하는 것보다 응답률은 높다. 하지만 A금융회사는 페이스북이 어떤 이유로 대상자를 선정했는지 알 수가 없다.

한돌, 알파고, 절예 등 많은 인공지능 바둑 프로그램이 등장했다. 중국의 절예는 세계 정상급의 프로기사에게 두 점을 잡아주고도 승률이 더 좋다. 하지만 절예가 둔 수를 왜 그렇게 두었는지 인공지능은 설명해주지 않는다.

알고리즘 설계자도 이유를 모른다. 인공지능의 판단 과정은 블랙박스인 것이다. 다시 말하면 인공지능의 의사결정 과정은 통제할 수 없다는 뜻이 된다. 과연 인공지능은 기업의 비즈니스 환경에 맞게 판단한 것일까? 윤리적으로 옳은 결정일까? 관련 법규는 충분히 검토한 것일까? 이유를 모른 채 인공지능의 판단 대로 행동하는 것이 맞는 것일까?

미국의 제스트파이낸스는 신용평점을 산출할 때 수천 개의 데이터 항목을 사용해서, 수십 개의 데이터를 사용하는 일반 은행보다 정확한 평점을 매기는 것으로 유명하다. 하지만 특정 개인의 신용 평점을 산출할 때, 수천 개의 데이터 항목 중에서 어떤 데이터가 결정적으로 영향을 미쳤는지를 알기는 쉽지 않다.

인공지능 오류도 발생할 수 있다. 이력서에 흑인 이름보다 백인 이름을 사용하는 경우, 채택될 확률이 50%가 높다는 연구 결과도 있다. 과거의 데이터로 생성된 편견을 인공지능이 그대로 학습한 결과일 것이다. 인공지능 알고리즘은 특정 집단에 유리하게 만들어질 수도 있다. OECD의 ‘알고리즘과 담합(Algorithm and Collusion)’ 보고서에 의하면 AI 알고리즘은 ‘시장 실패’를 유발할 수도 있다. 실시간 가격 조정 알고리즘은 운영자에게 유리한 의사결정을 내린다.

인공지능의 판단 과정을 알 수 없다면 적용은 제한적일 수 밖에 없다. 기업이 업무에 알고리즘을 적용한다면, 사용자의 ‘설명요구권(right to explanation)’을 보장해야 한다. 미국의 Equal Credit Opportunity Act는 개인의 신용 변동이 발생할 경우 이유를 설명해야 한다고 규정하고 있다. 2018년에 5월25일에 발효된 EU의 GDPR(General Data Protection Regulation)에 의해, 데이터 주체는 의사결정 과정의 설명을 요구할 수 있다. 금융회사가 소비자의 신용 등급 판정에 인공지능을 사용하고 있다면, 소비자의 등급 판정 결과의 이유를 설명해주어야 한다. 만약 설명할 수 없다면 인공지능을 이용할 수 없는 것이다.

정확성과 설명력의 트레이드오프

인공지능은 ‘단순 인공지능(Simple AI)’과 ‘복잡 인공지능(Complex AI)’으로 구분한다. 단순 인공지능은 회귀분석, 의사결정나무 등과 같은 알고리즘에 의해서 판단한다. 복잡 인공지능은 신경망 등과 같은 데이터학습에 의해 판단한다. 단순 인공지능은 설명하기는 좋지만 정확성은 떨어진다. 복잡 인공지능은 정확성은 높지만 과정을 설명하지 못한다. 설명할 수는 없지만 정확한 것이 좋은 것일까? 정확성은 떨어지더라도 이해하고 설명할 수 있는 것이 좋은 것일까?

[그림 1] 정확성과 설명력의 트레이드오프

자료원: https://towardsdatascience.com/the-balance-accuracy-vs-interpretability-1b3861408062

설명할 수 없다는 것은 단순한 문제는 아니다. 과정을 이해할 수 없다면 알고리즘에 오류가 있는지, 잘못된 의도가 있는지, 그리고 의도를 어떻게 조정할 수 있는 지 알 수가 없다. 현실적으로는 정확성은 떨어지더라도, 설명할 수 있는 방식이 선호되는 경향이다. 사람이 따라서 해볼 수 있고(simulatability), 완전히 이해할 수 있으며(algorithm transparency), 분석 모델의 부분들은 따로 독립적으로 설명가능하기(decomposability) 때문이다.

현장에서 데이터 분석가들은 경영진 또는 현업부서 임원으로부터 “어떻게 분석 결과를 내가 믿을 수 있지?”라는 질문을 많이 받고 있다. 대답하는 방법은, 알고리즘 생성 모델을 설명해주거나, 또는 모델 적용 결과의 이전 이후 모습을 보여주는 것이다. 하지만 질문자에게 명쾌한 해답을 주지는 못한다. 근본적인 방법은 추론 과정을 사람이 이해할 수 있도록 설명해주는 인공지능 기법을 만드는 것이다. 설명이 가능해지면, 알고리즘의 조작 가능성, 데이터의 편향성, 데이터 주체에 대한 법적 규제 등을 해결할 수 있을 것이다.

[그림 2] XAI의 개념

자료원: https://www.darpa.mil/program/explainable-artificial-intelligence

설명 가능한 인공지능 (XAI, Explainable Artificial Intelligence)

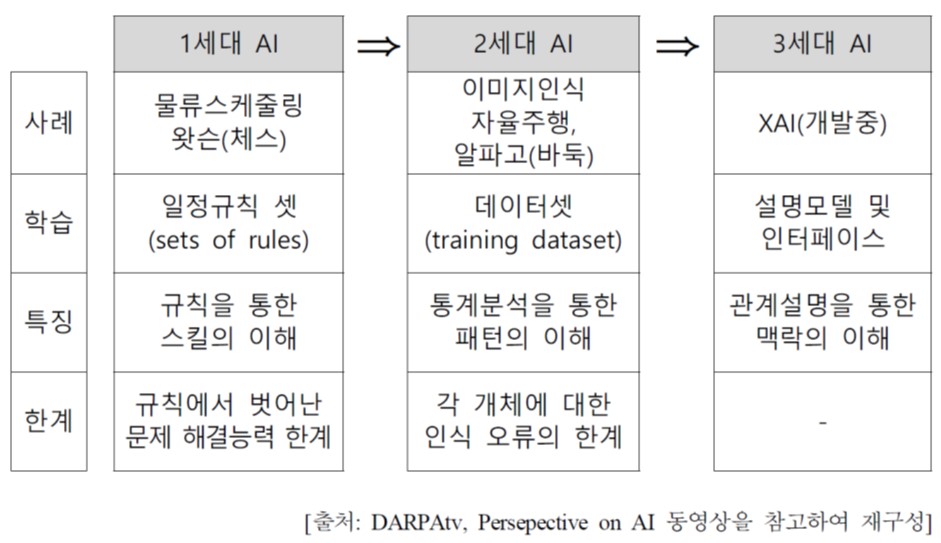

설명 가능한 인공지능은 인공지능의 행위와 판단을 사람이 이해할 수 있는 형태로 설명할 수 있는 인공지능을 의미한다. 미국 국방부 산하의 연구기관인 미국방연구원(DARPA , Defense Advanced Research Projects Agency)은 2017년에 시작하여 2021년 4월을 목표로, XAI를 개발 중이다. MIT와 구글 등에서도 활발하게 연구프로젝트가 진행 중이다. 우리나라는 정부의 ‘인공지능 국가전략프로젝트’의 일환으로 2017년 9월25일에 울산과학기술원에 ‘설명 가능한 인공지능 연구센터’가 문을 열었다.

미국방연구원의 XAI는 다음 세가지 과제 해결을 목표로 한다.

▶ 데이터를 학습하여 설명력을 갖춘 모델을 만드는 프로세스 개발

▶ 설명력을 갖춘 모델

▶ 사용자가 인공지능의 결정을 쉽게 이해할 수 있도록 설명해주는 기능

XAI가 현실화되는 것은 2022년 이후일 것이다. 인공지능 기술은 기업은 물론 개인의 일상생활 곳곳에 접목되고 있다. 인공지능 적용이 확산되기 위해서는 신뢰 문제가 해결되어야 한다. 현재의 인공지능은 성과는 탁월하지만 블랙박스 형태이기 때문에 금융, 의료, 군사 등 결정이 중대한 영향을 미치는 분야에는 적용되기 어려웠다. XAI는 인공지능과 사람의 상호 이해를 높일 뿐만 아니라, 사람에 의한 인공지능 통제를 가능하게 할 것이다. 또한 인공지능 적용에 따른 윤리적 법적 문제 해결에도 도움이 될 것이다. XAI로 진화는 인공지능 적용을 광범위하게 확대시킬 것으로 전망된다.

[그림 3] 인공지능의 진화(미국방연구원)

자료원: 한국정보화진흥원 요약(2018), 미 국방연구원의 설명가능 인공지능(XAI)

- 끝 -